To przede wszystkim transfer danych powoduje dużą część zużycia energii. Dotyczy to tym bardziej ogromnych ilości danych, z którymi pracują algorytmy sztucznej inteligencji.

Pominięcie tego kroku, który jest również uważany za wąskie gardło między pamięcią a procesami logicznymi, ma zatem ogromny wpływ. I właśnie w tym miejscu pojawia się pomysł z 2003 roku, opracowany wówczas na Uniwersytecie Minnesota.

Doprowadziło to do współpracy między wieloma dyscyplinami, od fizyki po inżynierię i informatykę. W rezultacie powstało wiele obwodów, które są dziś wykorzystywane w inteligentnych zegarkach i elementach pamięci.

W projekt zaangażowana była również pamięć CRAM (Computational Random Access Memory). Umożliwia ona rzeczywiste obliczanie i wykonywanie równoległych procesów bezpośrednio w pamięci głównej, a następnie w dowolnej lokalizacji.

Więcej niż tylko nowa architektura

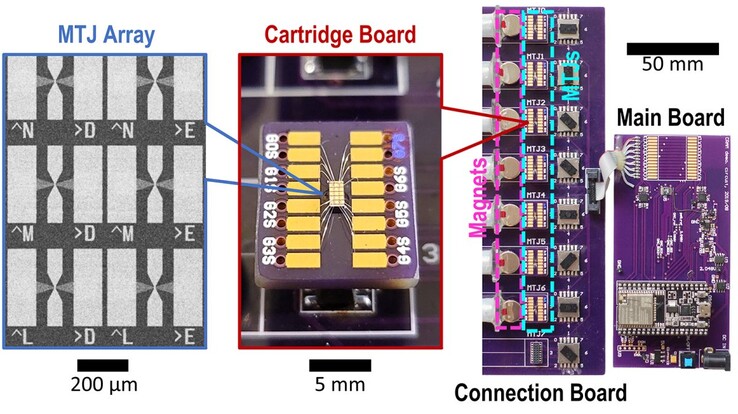

Co więcej, nie są to konwencjonalne obwody, ale magnetyczne styki tunelowe, które mogą wykorzystywać spin elektronów zamiast ładunku do przełączania między 0 a 1.

W zastosowaniach opartych na sztucznej inteligencji skutkuje to zużyciem energii na poziomie jednej tysięcznej, aby ostatecznie osiągnąć ten sam wynik, co w przypadku klasycznej metody. Obecne i prognozowane zużycie energii elektrycznej przez sieci neuronowe na całym świecie pokazuje, jak ogromna jest to ilość. Według Międzynarodowej Agencji Energii w 2022 roku zużyto 460 terawatogodzin. Oczekuje się, że najpóźniej do 2026 roku będzie to 1000 terawatogodzin.

Przy gigantycznym potencjale oszczędności wynoszącym 99,9 procent, pozostawiłoby to 999 terawatogodzin, które nie byłyby już potrzebne. Odpowiada to rocznemu zużyciu energii elektrycznej w Japonii, czwartej co do wielkości gospodarce z 126 milionami mieszkańców.

Według artykułu, nie byłby to nawet najlepszy możliwy wynik. Dalsze testy mogłyby zmniejszyć zużycie energii o współczynnik 1700 lub 2500. Ten dodatkowy wzrost wydajności jest możliwy dzięki ukierunkowanemu dostosowaniu CRAM do indywidualnych algorytmów, które mogą być obliczane jeszcze szybciej, a tym samym bardziej ekonomicznie.