OpenAI prezentuje GPT-4o mini w cenie 25x niższej niż GPT-4o, umożliwiając większej liczbie firm i użytkowników dostęp do wysokiej jakości sztucznej inteligencji

OpenAI zaprezentował GPT-4o mini w cenie ponad 25 razy niższej niż jego najwyżej oceniany GPT-4o, otwierając dostęp do wysokiej jakości sztucznej inteligencji dla większej liczby firm i użytkowników. GPT-4o mini został niezależnie sklasyfikowany wśród 10 najlepszych najbardziej wydajnych modeli AI dostępnych obecnie na rynku. GPT-4o mini osiąga dobre wyniki w wielu testach porównawczych AI, mimo że jest małym modelem LLM.

Duży model językowy (LLM) jest tworzony po treningu na milionach dokumentów i stanowi podstawę dla chatbota AI, takiego jak ChatGPT. Model zawiera następnie wektory matematyczne, które wiążą prawdopodobieństwo wystąpienia słów, obrazów i innych elementów. Na przykład prawdopodobieństwo, że "lód" pojawi się obok "śmietany" jest znacznie większe niż prawdopodobieństwo, że pojawi się obok "kamienia". Jednak duże LLM wykorzystuje dużą moc obliczeniową https://arxiv.org/pdf/2210.17331 i energii aby odpowiedzieć na podpowiedzi użytkownika, co równa się wysokim kosztom dla użytkowników. Przycinanie LLM może sprawić, że będą one mniejsze, tańsze i bardziej przyjazne dla środowiska, z kompromisem w postaci mniej dokładnych odpowiedzi.

Czytelnicy, którzy nie wiedzą, jak wykorzystać sztuczną inteligencję do lepszego wykonywania zadań biznesowych lub zarabiania większych pieniędzy, mogą przeczytać tę książkę na Amazon.

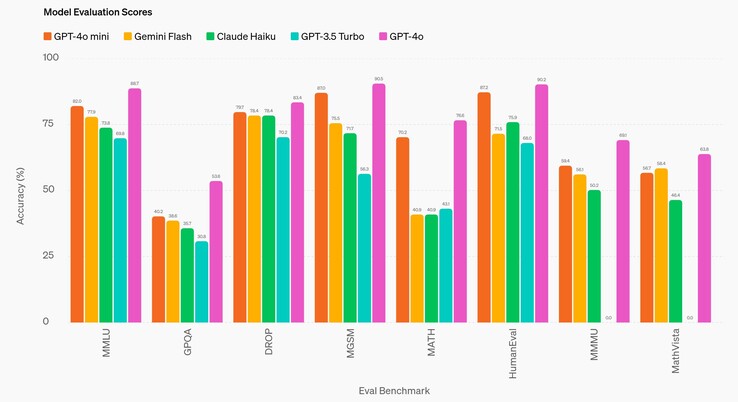

W bezpośrednim porównaniu z GPT-4o, najlepszym LLM OpenAI wydanym w 2024 roku, GPT-4o mini konsekwentnie daje mniej dokładne odpowiedzi. W porównaniu do GPT-3.5 Turbo z 2022 roku, GPT-4o mini konsekwentnie osiąga lepsze wyniki. W różnych testach porównawczych sztucznej inteligencji na poziomie uczelni (DROP, HumanEval, MATH, MathVista, MGSM, MMLUi MMMU), model odpowiada dokładnie na pytania w około 60-80% przypadków. Jedynie w przypadku testu na poziomie doktoranckim (GPQA) jego dokładność spada do około 40%, czyli tylko nieznacznie lepiej niż w przypadku osoby niebędącej ekspertem, szukającej odpowiedzi online.

Co ważne, podczas gdy GPT-4o kosztuje 5 USD/1 mln tokenów wejściowych i 15 USD/1 mln tokenów wyjściowych, GPT-4o mini kosztuje 0,15 USD/1 mln tokenów wejściowych i 0,60 USD/1 mln tokenów wyjściowych (1000 tokenów to około 750 słów). Jest to tańsze niż około osiemdziesięciu popularnych LLMw użyciu, z wyjątkiem mistral-embed.

GPT-4o mini ma okno kontekstu wejściowego 128K tokenów, czyli ilość tekstu, który może być analizowany jednocześnie, więc analiza dużych ilości dokumentów biznesowych i prawnych jest ograniczona. Okno wyjściowe jest ograniczone do 16 tys. tokenów. Model ma również granicę wiedzy z października 2023 r., więc wiadomości, wydarzenia i odkrycia, które mają miejsce po tej dacie, są nieznane sztucznej inteligencji i nie mogą być wykorzystywane w odpowiedziach na podpowiedzi.

Czytelnicy, którzy wciąż czekają na humanoidalne roboty AI, które będą dla nich gotować, takie jak prototyp prototyp 1X Neobędą musieli w międzyczasie zadowolić się robotami bez SI(takimi jak ten odkurzacz na Amazon).

Źródło(a)

18 lipca 2024 r

GPT-4o mini: rozwój ekonomicznej inteligencji

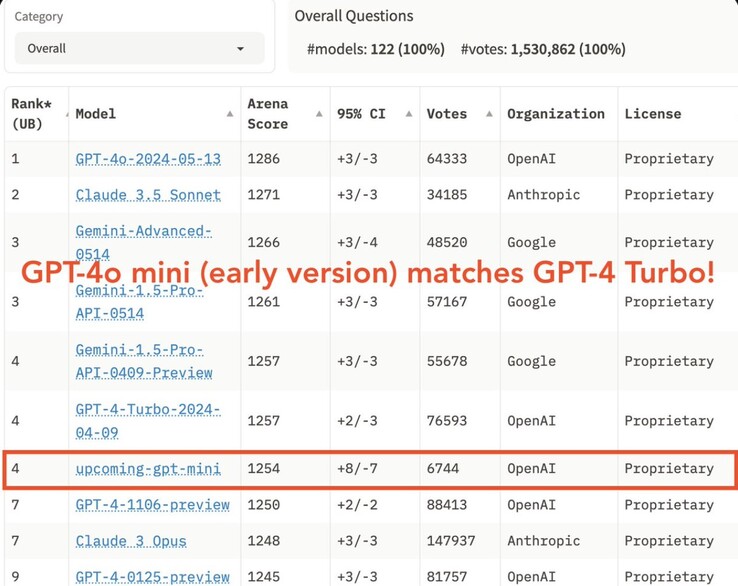

Przedstawiamy nasz najbardziej opłacalny mały model

OpenAI dokłada wszelkich starań, aby inteligencja była jak najszerzej dostępna. Dziś ogłaszamy GPT-4o mini, nasz najbardziej ekonomiczny mały model. Oczekujemy, że GPT-4o mini znacznie rozszerzy zakres aplikacji zbudowanych przy użyciu sztucznej inteligencji, czyniąc ją znacznie bardziej przystępną cenowo. GPT-4o mini osiąga 82% w MMLU i obecnie przewyższa GPT-41 w preferencjach czatu w tabeli liderów LMSYS (otwiera się w nowym oknie). Jego cena wynosi 15 centów za milion tokenów wejściowych i 60 centów za milion tokenów wyjściowych, co jest o rząd wielkości bardziej przystępne niż poprzednie modele frontier i ponad 60% tańsze niż GPT-3.5 Turbo.

GPT-4o mini umożliwia szeroki zakres zadań przy niskich kosztach i opóźnieniach, takich jak aplikacje, które łączą lub zrównoleglają wiele wywołań modelu (np. wywoływanie wielu interfejsów API), przekazują dużą ilość kontekstu do modelu (np. pełną bazę kodu lub historię konwersacji) lub wchodzą w interakcje z klientami poprzez szybkie odpowiedzi tekstowe w czasie rzeczywistym (np. chatboty obsługi klienta).

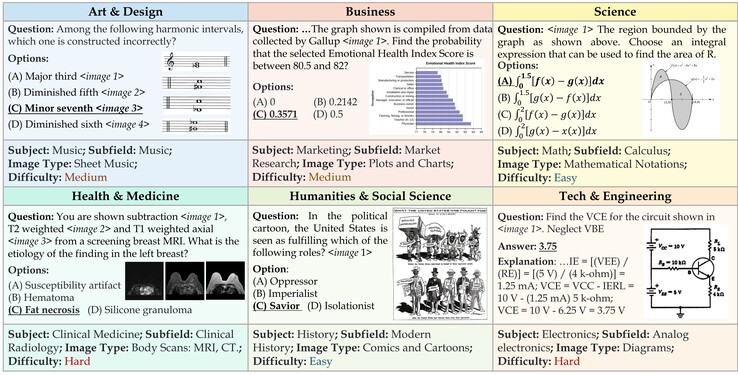

Obecnie GPT-4o mini obsługuje tekst i wizję w interfejsie API, a w przyszłości będzie obsługiwać wejścia i wyjścia tekstowe, graficzne, wideo i audio. Model ma okno kontekstowe 128K tokenów, obsługuje do 16K tokenów wyjściowych na żądanie i ma wiedzę do października 2023 roku. Dzięki ulepszonemu tokenizatorowi współdzielonemu z GPT-4o, obsługa tekstu nieanglojęzycznego jest teraz jeszcze bardziej opłacalna.

Mały model z doskonałą inteligencją tekstową i multimodalnym rozumowaniem

GPT-4o mini przewyższa GPT-3.5 Turbo i inne małe modele w akademickich testach porównawczych zarówno pod względem inteligencji tekstowej, jak i rozumowania multimodalnego, i obsługuje ten sam zakres języków co GPT-4o. Wykazuje również wysoką wydajność w wywoływaniu funkcji, co może umożliwić programistom tworzenie aplikacji pobierających dane lub podejmujących działania z systemami zewnętrznymi, a także lepszą wydajność w długim kontekście w porównaniu do GPT-3.5 Turbo.

GPT-4o mini został oceniony w kilku kluczowych testach porównawczych2.

Zadania rozumowania: GPT-4o mini jest lepszy niż inne małe modele w zadaniach rozumowania obejmujących zarówno tekst, jak i wizję, uzyskując 82,0% punktów w MMLU, benchmarku inteligencji tekstowej i rozumowania, w porównaniu do 77,9% dla Gemini Flash i 73,8% dla Claude Haiku.

Biegłość w matematyce i kodowaniu: GPT-4o mini wyróżnia się w zadaniach związanych z rozumowaniem matematycznym i kodowaniem, przewyższając poprzednie małe modele na rynku. W MGSM, mierzącym rozumowanie matematyczne, GPT-4o mini uzyskał wynik 87,0%, w porównaniu do 75,5% dla Gemini Flash i 71,7% dla Claude Haiku. GPT-4o mini uzyskał wynik 87,2% w HumanEval, który mierzy wydajność kodowania, w porównaniu do 71,5% dla Gemini Flash i 75,9% dla Claude Haiku.

Rozumowanie multimodalne: GPT-4o mini wykazuje również wysoką wydajność w MMMU, multimodalnej ocenie rozumowania, uzyskując 59,4% w porównaniu do 56,1% dla Gemini Flash i 50,2% dla Claude Haiku.

W ramach procesu opracowywania naszego modelu współpracowaliśmy z kilkoma zaufanymi partnerami, aby lepiej zrozumieć przypadki użycia i ograniczenia GPT-4o mini. Współpracowaliśmy z firmami takimi jak Ramp(otwiera się w nowym oknie) i Superhuman(otwiera się w nowym oknie), które stwierdziły, że GPT-4o mini radzi sobie znacznie lepiej niż GPT-3.5 Turbo w zadaniach takich jak wyodrębnianie ustrukturyzowanych danych z plików pokwitowań lub generowanie wysokiej jakości odpowiedzi na wiadomości e-mail, gdy są one dostarczane z historią wątków.

Wbudowane środki bezpieczeństwa

Bezpieczeństwo jest wbudowane w nasze modele od samego początku i wzmacniane na każdym etapie naszego procesu rozwoju. Podczas wstępnego szkolenia odfiltrowujemy (otwiera się w nowym oknie) informacje, z których nie chcemy, aby nasze modele uczyły się lub generowały dane wyjściowe, takie jak mowa nienawiści, treści dla dorosłych, witryny, które głównie gromadzą dane osobowe i spam. W post-treningu dostosowujemy zachowanie modelu do naszych zasad przy użyciu technik takich jak uczenie ze wzmocnieniem z ludzką informacją zwrotną (RLHF), aby poprawić dokładność i wiarygodność odpowiedzi modeli.

GPT-4o mini ma wbudowane te same środki bezpieczeństwa, co GPT-4o, które starannie oceniliśmy za pomocą zautomatyzowanych i ludzkich ocen zgodnie z naszymi ramami gotowości i zgodnie z naszymi dobrowolnymi zobowiązaniami. Ponad 70 zewnętrznych ekspertów z dziedzin takich jak psychologia społeczna i dezinformacja przetestowało GPT-4o w celu zidentyfikowania potencjalnych zagrożeń, którymi się zajęliśmy i planujemy podzielić się szczegółami w nadchodzącej karcie systemu GPT-4o i karcie wyników gotowości. Spostrzeżenia z tych ocen ekspertów pomogły poprawić bezpieczeństwo zarówno GPT-4o, jak i GPT-4o mini.

Opierając się na tych wnioskach, nasze zespoły pracowały również nad poprawą bezpieczeństwa GPT-4o mini przy użyciu nowych technik opartych na naszych badaniach. GPT-4o mini w API jest pierwszym modelem, w którym zastosowano naszą metodę hierarchii instrukcji (otwiera się w nowym oknie), która pomaga poprawić odporność modelu na jailbreaki, wstrzyknięcia promptów i wyodrębnianie promptów systemowych. Dzięki temu odpowiedzi modelu są bardziej wiarygodne i bezpieczniejsze w użyciu w aplikacjach na dużą skalę.

Będziemy nadal monitorować sposób korzystania z GPT-4o mini i poprawiać bezpieczeństwo modelu w miarę identyfikowania nowych zagrożeń.

Dostępność i ceny

GPT-4o mini jest teraz dostępny jako model tekstowy i wizyjny w Assistants API, Chat Completions API i Batch API. Deweloperzy płacą 15 centów za 1 mln tokenów wejściowych i 60 centów za 1 mln tokenów wyjściowych (mniej więcej równowartość 2500 stron w standardowej książce). W najbliższych dniach planujemy wprowadzić dopracowanie dla GPT-4o mini.

W ChatGPT, użytkownicy Free, Plus i Team będą mogli uzyskać dostęp do GPT-4o mini od dziś, zamiast GPT-3.5. Użytkownicy korporacyjni również uzyskają dostęp od przyszłego tygodnia, zgodnie z naszą misją, aby korzyści płynące ze sztucznej inteligencji były dostępne dla wszystkich.

Co dalej

W ciągu ostatnich kilku lat byliśmy świadkami niezwykłego postępu w inteligencji AI w połączeniu ze znaczną redukcją kosztów. Na przykład koszt jednego tokena GPT-4o mini spadł o 99% od czasu wprowadzenia w 2022 r. mniej wydajnego modelu text-davinci-003. Zależy nam na kontynuowaniu tej trajektorii obniżania kosztów przy jednoczesnym zwiększaniu możliwości modeli.

Wyobrażamy sobie przyszłość, w której modele zostaną płynnie zintegrowane z każdą aplikacją i na każdej stronie internetowej. GPT-4o mini toruje drogę programistom do tworzenia i skalowania potężnych aplikacji AI w bardziej wydajny i przystępny sposób. Przyszłość sztucznej inteligencji staje się coraz bardziej dostępna, niezawodna i osadzona w naszych codziennych cyfrowych doświadczeniach, a my jesteśmy podekscytowani, że możemy nadal przewodzić.

Autor

OpenAI

Podziękowania

Liderzy: Jacob Menick, Kevin Lu, Shengjia Zhao, Eric Wallace, Hongyu Ren, Haitang Hu, Nick Stathas, Felipe Petroski Such

Lider programu: Mianna Chen

Wkład odnotowany w openai.com/gpt-4o-contributions/

Przypisy

1

Od 18 lipca 2024 r. wcześniejsza wersja GPT-4o mini przewyższa GPT-4T 01-25.

2

Liczby Eval dla GPT-4o mini są obliczane przy użyciu naszego repozytorium simple-evals(otwiera się w nowym oknie) z monitem komunikatu systemowego asystenta API. W przypadku konkurencyjnych modeli, bierzemy maksymalną liczbę ponad ich zgłoszoną liczbę (jeśli jest dostępna), tabelę liderów HELM(otwiera się w nowym oknie) i naszą własną reprodukcję za pomocą simple-evals.