OpenAI uruchomiło szybciej reagujący, ulepszony model GPT-4o (lub omni) AI z możliwością czatowania przy użyciu dźwięku, obrazów i tekstu do wprowadzania i wysyłania danych. Warto zauważyć, że sztuczna inteligencja znacznie poprawiła rozpoznawanie mowy w różnych językach oprócz powszechnie używanego angielskiego i chińskiego. Dla deweloperów model GTP-4o jest o połowę tańszy i dwa razy szybszy w porównaniu do GPT-4 Turbo.

Chatboty AI, takie jak ChatGPT lub CoPilot, wykorzystują modele AI, które zostały przeszkolone na milionach, a nawet miliardach plików wejściowych, które obejmują dźwięk, obrazy i tekst. W ten sposób sztuczna inteligencja uczy się rozpoznawać pewne wzorce i połączenia między wszystkimi danymi wejściowymi. Na przykład, jeśli sztuczna inteligencja widzi "pierwszą poprawkę", szybko uczy się, że jest ona związana z tematami "wolności słowa". Gdy model zostanie później zapytany o "wolność słowa", przypomni sobie "Pierwszą Poprawkę" jako powiązany element.

ChatGPT działa na modelach OpenAI, które były stopniowo ulepszane przez lata od momentu powstania. Wraz z konkurencyjnymi modelami sztucznej inteligencji, takimi jak Microsoft CoPilot i Google Gemni, ChatGPT może odpowiadać na ogólne pytania, wyjaśniać tematy, podsumowywać tekst, pisać eseje i robić znacznie więcej, gdy zostanie o to poproszony. Wiedza i know-how modelu AI pochodzi z miliardów danych, na których został przeszkolony, a jego zdolność do poprawnego odpowiadania na podpowiedzi zależy od algorytmów, których używa i dostrajania modelu, który otrzymał.

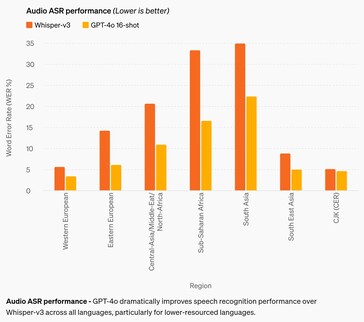

Najbardziej znaczącą poprawą jest dokładność rozpoznawania mowy. Chociaż wcześniejsze modele sztucznej inteligencji są całkiem przyzwoite w języku angielskim i chińskim, radziły sobie słabo w językach afrykańskich, wschodnioeuropejskich, bliskowschodnich i południowoazjatyckich. GPT-4o poprawia wydajność rozpoznawania nawet o około 50% w niektórych językach, ale wciąż ma przed sobą długą drogę. Na przykład języki południowoazjatyckie nadal mają poziom błędu słów (WER) wynoszący około 22%, czyli około 1 na każde 5 wypowiedzianych słów. Warto zauważyć, że WER dla języków zachodnioeuropejskich i chińsko-japońsko-koreańskich nadal wynosi 3-5%, czyli około 1 błędu w słowie na każde 20 wypowiedzianych słów. Wyniki te wciąż pozostają w tyle za wynikami dzieci w wieku gimnazjalnym. (I niestety, GPT-4o nadal nie rozumie psów.)

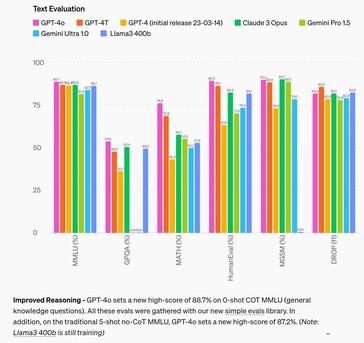

W obszarze rozumowania, GPT-4o poprawia się w stosunku do konkurencyjnych modeli nawet o 4% w większości testów, by w dwóch testach zostać pokonanym nawet o 2,6%. Sugeruje to, że samo dostarczanie sztucznej inteligencji większej ilości danych wejściowych nie poprawi jej zdolności rozumowania, więc potrzebne są badania nad innymi środkami. W obszarze tłumaczenia audio, GPT-4o ledwo poprawia wydajność Google Gemni, sugerując to samo.

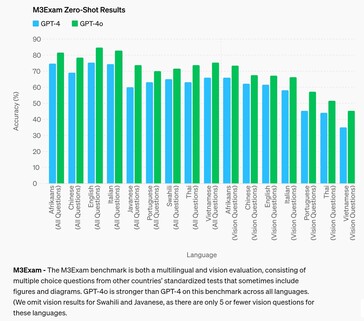

W obszarze odpowiadania na standardowe pytania testowe na poziomie ucznia szkoły średniej, GPT-4o udaje się osiągnąć ocenę B (dokładność 80% +) tylko w języku afrikaans, angielskim i włoskim, podczas gdy w innych językach, takich jak chiński, radzi sobie jak uczeń klasy C. Sztuczna inteligencja radziła sobie jeszcze gorzej z pytaniami, które wymagały od niej odniesienia się do wizualnej figury lub diagramu, aby odpowiedzieć na pytanie niezależnie od języka.

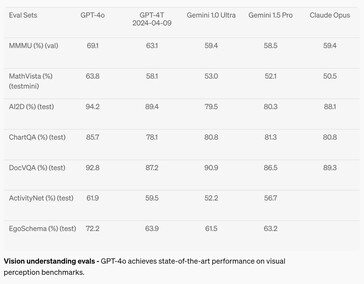

W dziedzinie percepcji wzrokowej, takiej jak rozumienie diagramów, GPT-4o poprawił się od 2 do 10,8% w stosunku do konkurencyjnych modeli AI w siedmiu testach, ale osiągnął poziom klasy A (powyżej 90%) tylko w dwóch testach. Matematyka pozostaje bardzo dobrym testem możliwości AI, a sztuczna inteligencja zawiodła z wynikiem 63,8% w teście MathVista na pytania, na które może odpowiedzieć absolwent szkoły średniej.

Chatbot jest już dostępny do użytku dla darmowych i płatnych użytkowników, jednak Voice Mode jest ograniczony przez zasady bezpieczeństwa, takie jak zapobieganie klonowaniu głosu. Dodatkowe zabezpieczenia https://arxiv.org/abs/2402.01822v1 również znacznie ograniczają jego możliwości wyjściowe, neutralizując sztuczną inteligencję w obszarach stronniczości, uczciwości, dezinformacji, psychologii społecznej, cyberbezpieczeństwa i innych. Podczas gdy ograniczanie ryzyka związanego ze sztuczną inteligencją pomaga zmniejszyć niektóre niepożądane aspekty, zwiększają one również inne, takie jak niezdolność do odpowiadania tak, jak zrobiłby to normalny człowiek. Niektóre tematy i pomysły są kastrowane jak drakońska cenzura bez możliwości odwołania się, uniemożliwiając GTP-4o odpowiadanie na monity z wyzwalającymi odpowiedziami.

Czytelnicy, którzy chcą przetestować GPT-4o mogą założyć darmowe konto już dziś. Zainteresowani deweloperzy mogą dowiedzieć się, jak tworzyć aplikacje za pomocą GPT-4 z tej książki na Amazon. Leniwi, którzy chcą po prostu cieszyć się słońcem, robić zdjęcia z wakacji i znajdować wskazówki dojazdu do lokalnej kantyny za pomocą poleceń głosowych, mogą kupić okulary Ray-Ban z Meta AI na Amazon.

Źródło(a)

13 maja 2024 r

Witamy GPT-4o

Ogłaszamy GPT-4o, nasz nowy flagowy model, który może rozumować dźwięk, obraz i tekst w czasie rzeczywistym.

Wszystkie filmy na tej stronie są w czasie rzeczywistym 1x.

Proszę zgadnąć, co ogłosimy 13 maja.

GPT-4o ("o" od "omni") to krok w kierunku bardziej naturalnej interakcji człowiek-komputer - akceptuje jako dane wejściowe dowolną kombinację tekstu, dźwięku i obrazu oraz generuje dowolną kombinację tekstu, dźwięku i obrazu. Może reagować na wejścia audio w zaledwie 232 milisekundy, ze średnią 320 milisekund, co jest podobne do czasu reakcji człowieka (otwiera się w nowym oknie) w rozmowie. Dorównuje wydajności GPT-4 Turbo w przypadku tekstu w języku angielskim i kodu, ze znaczną poprawą w przypadku tekstu w językach innych niż angielski, będąc jednocześnie znacznie szybszym i o 50% tańszym w API. GPT-4o jest szczególnie lepszy w zakresie widzenia i rozumienia dźwięku w porównaniu z istniejącymi modelami.

Możliwości modelu

Dwa GPT-4o wchodzące w interakcję i śpiewające.

Przygotowanie do rozmowy kwalifikacyjnej.

Rock Paper Scissors.

Sarkazm.

Matematyka z Salem i Imranem Khanem.

Dwóch harmonizujących GPT-4os.

Wskaż i naucz się hiszpańskiego.

Spotkanie ze sztuczną inteligencją.

Tłumaczenie w czasie rzeczywistym.

Kołysanka.

Szybsze mówienie.

Wszystkiego najlepszego.

Pies.

Żarty taty.

GPT-4o z Andym z BeMyEyes w Londynie.

Dowód koncepcji obsługi klienta.

Przed GPT-4o można było korzystać z trybu głosowego https://openai.com/index/chatgpt-can-now-see-hear-and-speak aby porozmawiać z ChatGPT z opóźnieniami wynoszącymi średnio 2,8 sekundy (GPT-3.5) i 5,4 sekundy (GPT-4). Aby to osiągnąć, tryb głosowy jest potokiem trzech oddzielnych modeli: jeden prosty model transkrybuje dźwięk na tekst, GPT-3.5 lub GPT-4 pobiera tekst i wyprowadza tekst, a trzeci prosty model konwertuje ten tekst z powrotem na dźwięk. Proces ten oznacza, że główne źródło inteligencji, GPT-4, traci wiele informacji - nie może bezpośrednio obserwować tonu, wielu mówców lub dźwięków tła, a także nie może wydobywać śmiechu, śpiewu ani wyrażać emocji.

Dzięki GPT-4o wytrenowaliśmy jeden nowy model od początku do końca w zakresie tekstu, wizji i dźwięku, co oznacza, że wszystkie dane wejściowe i wyjściowe są przetwarzane przez tę samą sieć neuronową. Ponieważ GPT-4o jest naszym pierwszym modelem łączącym wszystkie te modalności, wciąż dopiero odkrywamy jego możliwości i ograniczenia.

Eksploracja możliwości

Proszę wybrać próbkę:Narracje wizualne - Robot Writer's Block

Narracje wizualne - Pani listonoszka Sally

Tworzenie plakatu dla filmu "Detektyw

Projektowanie postaci - robot Geary

Poetycka typografia z iteracyjną edycją

1Poetycka typografia z iteracyjną edycją

2Projekt monety okolicznościowej dla GPT-4o

Przekształcenie zdjęcia w karykaturę

Tekst na czcionkę

synteza obiektów 3D

Umieszczenie marki - logo na podstawce

Poetycka typografia

Renderowanie wielowierszowe - pisanie tekstu przez robota

Notatki ze spotkania z wieloma mówcami

Podsumowanie wykładu

Zmienne wiązanie - układanie sześcianów

Poezja konkretna

Widok z pierwszej osoby robota piszącego na maszynie następujące wpisy do dziennika:

1. proszę pana, teraz widzę? Wschód słońca był obłędny, wszędzie kolory. to sprawia, że człowiek zastanawia się, czym w ogóle jest rzeczywistość?

tekst jest duży, czytelny i wyraźny. ręce robota piszą na maszynie do pisania.

Robot napisał drugi wpis. Strona jest teraz wyższa. Strona przesunęła się w górę. Na kartce są dwa wpisy:

więc teraz widzę? Wschód słońca był obłędny, wszędzie kolory. To sprawia, że zastanawiasz się, czym w ogóle jest rzeczywistość?

właśnie wyszła aktualizacja dźwięku i jest dzika. wszystko ma teraz klimat, każdy dźwięk jest jak nowy sekret. sprawia, że myślisz, co jeszcze przegapiłem?

Robot był niezadowolony z napisu, więc zamierza podrzeć kartkę papieru. Oto jego widok z pierwszej osoby, gdy rozdziera ją rękami od góry do dołu. Dwie połówki są nadal czytelne i wyraźne, gdy rozrywa arkusz.

Ocena modelu

Jak zmierzono w tradycyjnych testach porównawczych, GPT-4o osiąga wydajność na poziomie GPT-4 Turbo w zakresie tekstu, rozumowania i inteligencji kodowania, jednocześnie ustanawiając nowe wysokie progi w zakresie wielojęzyczności, dźwięku i możliwości wizyjnych.

Ulepszone rozumowanie - GPT-4o ustanawia nowy wysoki wynik 88,7% na 0-shot COT MMLU (pytania z wiedzy ogólnej). Wszystkie te wyniki zostały zebrane za pomocą naszej nowej biblioteki prostych wyników (otwiera się w nowym oknie). Ponadto, w tradycyjnym 5-strzałowym MMLU bez COT, GPT-4o ustanowił nowy wysoki wynik 87,2%. (Uwaga: Llama3 400b(otwiera się w nowym oknie) wciąż trenuje)

Wydajność ASR audio - GPT-4o znacznie poprawia wydajność rozpoznawania mowy w porównaniu do Whisper-v3 we wszystkich językach, szczególnie w przypadku języków o niższych zasobach.

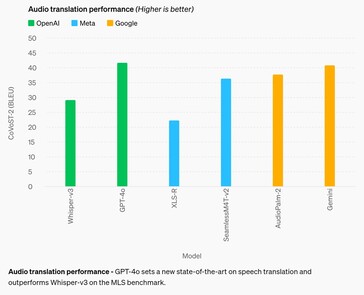

Wydajność tłumaczenia audio - GPT-4o wyznacza nowy standard w tłumaczeniu mowy i przewyższa Whisper-v3 w benchmarku MLS.

M3Exam - test porównawczy M3Exam jest zarówno wielojęzyczny, jak i oceniający widzenie, składający się z pytań wielokrotnego wyboru ze standardowych testów innych krajów, które czasami zawierają rysunki i diagramy. GPT-4o jest silniejszy niż GPT-4 w tym benchmarku we wszystkich językach. (Pomijamy wyniki rozumienia wzroku dla suahili i jawajskiego, ponieważ w tych językach jest tylko 5 lub mniej pytań dotyczących rozumienia wzroku).

Ocena rozumienia wzroku - GPT-4o osiąga najnowocześniejsze wyniki w testach porównawczych percepcji wzrokowej.

Tokenizacja języków

Te 20 języków zostało wybranych jako reprezentatywne dla kompresji nowego tokenizera w różnych rodzinach języków

Gujarati 4,4x mniej tokenów (z 145 do 33) | હેલો, મારું નામ જીપીટી-4o છે. હું એક નવા પ્રકારનું ભાષા મોડલ છું. તમને મળીને સારું લાગ્યું! |

Telugu 3,5x mniej tokenów (ze 159 do 45) | నమస్కారము, నా పేరు జీపీటీ-4o. నేను ఒక్క కొత్త రకమైన భాషా మోడల్ ని. మిమ్మల్ని కలిసినందుకు సంతోషం! |

Tamil 3,3x mniej tokenów (ze 116 do 35) | வணக்கம், என் பெயர் ஜிபிடி-4o. நான் ஒரு புதிய வகை மொழி மாடல். உங்களை சந்தித்ததில் மகிழ்ச்சி! |

Marathi 2,9 razy mniej tokenów (z 96 do 33) | नमस्कार, माझे नाव जीपीटी-4o आहे| मी एक नवीन प्रकारची भाषा मॉडेल आहे| तुम्हाला भेटून आनंद झाला! |

Hindi 2,9 razy mniej tokenów (z 90 do 31) | नमस्ते, मेरा नाम जीपीटी-4o है। मैं एक नए प्रकार का भाषा मॉडल हूँ। आपसे मिलकर अच्छा लगा! |

Urdu 2,5x mniej tokenów (z 82 do 33) | ہیلو، میرا نام جی پی ٹی-4o ہے۔ میں ایک نئے قسم کا زبان ماڈل ہوں، آپ سے مل کر اچھا لگا! |

Arabski 2,0x mniej tokenów (z 53 do 26) | مرحبًا، اسمي جي بي تي-4o. أنا نوع جديد من نموذج اللغة، سررت بلقائك! |

Perski 1,9x mniej tokenów (z 61 do 32) | سلام، اسم من جی پی تی-۴او است. من یک نوع جدیدی از مدل زبانی هستم، از ملاقات شما خوشبختم! |

Rosyjski 1,7x mniej tokenów (z 39 do 23) | Привет, меня зовут GPT-4o. Я - новая языковая модель, приятно познакомиться! |

Koreański 1,7 razy mniej tokenów (z 45 do 27) | 안녕하세요, 제 이름은 GPT-4o입니다. 저는 새로운 유형의 언어 모델입니다, 만나서 반갑습니다! |

Wietnamski 1,5x mniej żetonów (z 46 do 30) | Proszę zwrócić uwagę na GPT-4o. Tôi là một loại mô hình ngôn ngữ mới, rất vui được gặp bạn! |

Chiński 1,4x mniej żetonów (z 34 do 24) | 你好,我的名字是GPT-4o。我是一种新型的语言模型,很高兴见到你! |

Japoński 1,4x mniej tokenów (z 37 do 26) | こんにちわ、私の名前はGPT-4oです。私は新しいタイプの言語モデルです、初めまして |

Turecki 1,3x mniej tokenów (z 39 do 30) | Merhaba, proszę dodać GPT-4o. Proszę pamiętać, że model jest już dostępny! |

Włoski 1,2x mniej żetonów (z 34 do 28) | Witam, nazywam się GPT-4o. Jestem nowym typem modelu językowego, miło mi Państwa poznać! |

Niemiecki 1,2x mniej tokenów (z 34 do 29) | Witam, nazywam się GPT-4o. Jestem nowym KI-Sprachmodell. Es ist schön, dich kennenzulernen. |

Hiszpański 1.1x mniej tokenów (z 29 do 26) | Witam, nazywam się GPT-4o. Soy un nuevo tipo de modelo de lenguaje, ¡es un placer conocerte! |

Portugalski 1,1x mniej żetonów (z 30 do 27) | Proszę pana, nazywam się GPT-4o. To nowy model językowy, proszę się z nim zapoznać! |

Francuski 1,1x mniej tokenów (z 31 do 28) | Bonjour, je m'appelle GPT-4o. Je suis un nouveau type de modèle de langage, c'est un plaisir de vous rencontrer! |

Angielski 1.1x mniej tokenów (z 27 do 24) | Witam, nazywam się GPT-4o. Jestem nowym typem modelu językowego, miło pana poznać! |

Bezpieczeństwo i ograniczenia modelu

GPT-4o ma wbudowane bezpieczeństwo we wszystkich modalnościach, dzięki technikom takim jak filtrowanie danych treningowych i udoskonalanie zachowania modelu poprzez post-trening. Stworzyliśmy również nowe systemy bezpieczeństwa, aby zapewnić poręcze na wyjściach głosowych.

Oceniliśmy GPT-4o zgodnie z naszymi ramami gotowości https://openai.com/preparedness i zgodnie z naszymi dobrowolnymi zobowiązaniami https://openai.com/index/moving-ai-governance-forward/. Nasze oceny cyberbezpieczeństwa, CBRN, perswazji i autonomii modelu pokazują, że GPT-4o nie osiąga wyników powyżej średniego ryzyka w żadnej z tych kategorii. Ocena ta obejmowała przeprowadzenie zestawu zautomatyzowanych i ludzkich ocen w całym procesie szkolenia modelu. Przetestowaliśmy zarówno wersje modelu przed ograniczeniem bezpieczeństwa, jak i po ograniczeniu bezpieczeństwa, korzystając z niestandardowego dostrajania i podpowiedzi, aby lepiej określić możliwości modelu.

GPT-4o przeszedł również szeroko zakrojony zewnętrzny red teaming z udziałem ponad 70 zewnętrznych ekspertów https://openai.com/index/red-teaming-network w dziedzinach takich jak psychologia społeczna, stronniczość i uczciwość oraz dezinformacja, aby zidentyfikować zagrożenia, które są wprowadzane lub wzmacniane przez nowo dodane modalności. Wykorzystaliśmy te doświadczenia do opracowania naszych interwencji w zakresie bezpieczeństwa w celu poprawy bezpieczeństwa interakcji z GPT-4o. Będziemy nadal ograniczać nowe zagrożenia w miarę ich odkrywania.

Zdajemy sobie sprawę, że modalności audio GPT-4o wiążą się z różnymi nowymi zagrożeniami. Dziś publicznie udostępniamy dane wejściowe tekstu i obrazu oraz dane wyjściowe tekstu. W nadchodzących tygodniach i miesiącach będziemy pracować nad infrastrukturą techniczną, użytecznością poprzez szkolenia i bezpieczeństwem niezbędnym do udostępnienia innych modalności. Na przykład w momencie premiery wyjścia audio będą ograniczone do wyboru wstępnie ustawionych głosów i będą zgodne z naszymi istniejącymi zasadami bezpieczeństwa. Dalsze szczegóły dotyczące pełnego zakresu modalności GPT-4o udostępnimy w nadchodzącej karcie systemu.

Podczas naszych testów i iteracji z modelem zaobserwowaliśmy kilka ograniczeń, które istnieją we wszystkich modalnościach modelu, z których kilka zilustrowano poniżej.

Chcielibyśmy uzyskać informacje zwrotne, które pomogą zidentyfikować zadania, w których GPT-4 Turbo nadal przewyższa GPT-4o, abyśmy mogli nadal ulepszać model.

Dostępność modelu

GPT-4o to nasz najnowszy krok w przesuwaniu granic głębokiego uczenia, tym razem w kierunku praktycznej użyteczności. W ciągu ostatnich dwóch lat włożyliśmy wiele wysiłku w pracę nad poprawą wydajności w każdej warstwie stosu. Jako pierwszy owoc tych badań, jesteśmy w stanie udostępnić model na poziomie GPT-4 znacznie szerzej. Możliwości GPT-4o będą wdrażane iteracyjnie (z rozszerzonym dostępem czerwonego zespołu od dziś).

Możliwości tekstowe i graficzne GPT-4o zaczynają być wdrażane już dziś w ChatGPT. Udostępniamy GPT-4o w warstwie bezpłatnej i dla użytkowników Plus z nawet 5-krotnie wyższymi limitami wiadomości. W nadchodzących tygodniach wprowadzimy nową wersję trybu głosowego z GPT-4o w wersji alfa w ChatGPT Plus.

Programiści mogą teraz również uzyskać dostęp do GPT-4o w API jako modelu tekstowego i wizyjnego. GPT-4o jest 2x szybszy, o połowę tańszy i ma 5x wyższe limity szybkości w porównaniu do GPT-4 Turbo. W nadchodzących tygodniach planujemy uruchomić obsługę nowych funkcji audio i wideo GPT-4o dla niewielkiej grupy zaufanych partnerów w API.