OpenAI zaprezentowało swój najnowszy duży model językowy AI, o3-mini, który jest szybszy i lepszy niż jego poprzednik o1-mini w dostarczaniu dokładnych odpowiedzi. Model ten jest pierwszym małym modelem rozumowania LLM firmy dostępnym do bezpłatnego użytku publicznego dla wszystkich posiadaczy kont ChatGPT.

Model o3-mini można uruchomić przy użyciu trzech poziomów wysiłku rozumowania - niskiego, średniego i wysokiego. Każdy posiadacz darmowego konta ChatGPT może uruchomić o3-mini za darmo na średnim poziomie rozumowania, podczas gdy posiadacze płatnych kont mogą wybrać niski lub wysoki poziom rozumowania. Płatni użytkownicy ChatGPT Plus, Team i Pro mają natychmiastowy dostęp do o3-mini już dziś, podczas gdy użytkownicy Enterprise muszą poczekać do lutego. Programiści pragnący tworzyć najlepsze aplikacje oparte na OpenAI o3-mini API mogą przeczytać, jak to zrobić, w tej książce na Amazon.

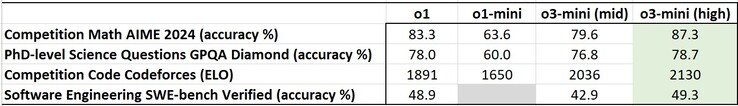

Ogólnie rzecz biorąc, o3-mini po ustawieniu na średni lub wysoki tryb rozumowania przewyższa o1-mini w standardowych testach porównawczych sztucznej inteligencji, w tym tych, które wymagają od sztucznej inteligencji rozumowania problemów. Po ustawieniu wysokiego trybu rozumowania, o3-mini udaje się również prześcignąć większy model o1 w niektórych testach porównawczych, ale brakuje mu zdolności o1 do oglądania obrazów i przetwarzania danych wizualnych.

Warto zauważyć, że o3-mini dostarcza odpowiedzi o 24% lub około 2,46 sekundy szybciej niż o1-mini. Pomaga to skrócić czas oczekiwania na udzielenie odpowiedzi przez ChatGPT i zmniejszyć emisję dwutlenku węgla wytwarzaną przez komputery z o3-mini. Chociaż o3-mini jest szybsze, hakerzy będą rozczarowani, ponieważ jego możliwości wykorzystania do ataków cyberbezpieczeństwa zostały znacznie ograniczone.

31 stycznia 2025 r

OpenAI o3-mini

Przesuwanie granicy opłacalnego rozumowania.

Wydajemy OpenAI o3-mini, najnowszy, najbardziej opłacalny model z naszej serii rozumowania, dostępny dziś zarówno w ChatGPT, jak i API. Zaprezentowany w grudniu 2024 r., ten potężny i szybki model przesuwa granice tego, co mogą osiągnąć małe modele, zapewniając wyjątkowe możliwości STEM - ze szczególną siłą w naukach ścisłych, matematyce i kodowaniu - przy jednoczesnym zachowaniu niskiego kosztu i zmniejszonego opóźnienia OpenAI o1-mini.

OpenAI o3-mini to nasz pierwszy mały model rozumowania, który obsługuje bardzo pożądane funkcje programistyczne, w tym wywoływanie funkcji (otwiera się w nowym oknie), ustrukturyzowane dane wyjściowe (otwiera się w nowym oknie) i komunikaty programistyczne (otwiera się w nowym oknie), dzięki czemu jest gotowy do produkcji od samego początku. Podobnie jak OpenAI o1-mini i OpenAI o1-preview, o3-mini będzie obsługiwać streaming(otwiera się w nowym oknie). Ponadto deweloperzy mogą wybierać między trzema opcjami wysiłku (otwiera się w nowym oknie) - niskim, średnim i wysokim - aby zoptymalizować je pod kątem konkretnych przypadków użycia. Ta elastyczność pozwala o3-mini "myśleć intensywniej", gdy mierzy się ze złożonymi wyzwaniami lub priorytetowo traktować szybkość, gdy problemem jest opóźnienie. o3-mini nie obsługuje funkcji wizyjnych, więc programiści powinni nadal używać OpenAI o1 do zadań rozumowania wizualnego. o3-mini jest wdrażane w Chat Completions API, Assistants API i Batch API od dziś dla wybranych programistów na poziomach wykorzystania API 3-5 (otwiera się w nowym oknie).

Użytkownicy ChatGPT Plus, Team i Pro mogą uzyskać dostęp do OpenAI o3-mini od dziś, a dostęp Enterprise pojawi się w lutym. o3-mini zastąpi OpenAI o1-mini w selektorze modeli, oferując wyższe limity szybkości i mniejsze opóźnienia, co czyni go atrakcyjnym wyborem do kodowania, STEM i logicznego rozwiązywania problemów. W ramach tej aktualizacji potrajamy limit szybkości dla użytkowników Plus i Team z 50 wiadomości dziennie z o1-mini do 150 wiadomości dziennie z o3-mini. Ponadto o3-mini współpracuje teraz z wyszukiwarką, aby znaleźć aktualne odpowiedzi z linkami do odpowiednich źródeł internetowych. Jest to wczesny prototyp, ponieważ pracujemy nad integracją wyszukiwania w naszych modelach rozumowania.

Od dziś użytkownicy planu darmowego mogą również wypróbować OpenAI o3-mini, wybierając opcję "Reason" w kreatorze wiadomości lub regenerując odpowiedź. To pierwszy raz, kiedy model rozumowania został udostępniony darmowym użytkownikom w ChatGPT.

Podczas gdy OpenAI o1 pozostaje naszym szerszym modelem rozumowania wiedzy ogólnej, OpenAI o3-mini stanowi wyspecjalizowaną alternatywę dla dziedzin technicznych wymagających precyzji i szybkości. W ChatGPT o3-mini wykorzystuje średni wysiłek rozumowania, aby zapewnić zrównoważony kompromis między szybkością a dokładnością. Wszyscy płatni użytkownicy będą mieli również możliwość wybrania o3-mini-high w selektorze modeli dla wersji o wyższej inteligencji, która generuje odpowiedzi nieco dłużej. Użytkownicy Pro będą mieli nieograniczony dostęp zarówno do o3-mini, jak i o3-mini-high.

Szybki, wydajny i zoptymalizowany pod kątem rozumowania STEM

Podobnie jak poprzednik OpenAI o1, OpenAI o3-mini został zoptymalizowany pod kątem rozumowania STEM. o3-mini ze średnim wysiłkiem rozumowania dorównuje wydajności o1 w matematyce, kodowaniu i naukach ścisłych, zapewniając jednocześnie szybsze odpowiedzi. Oceny przeprowadzone przez testerów-ekspertów wykazały, że o3-mini daje dokładniejsze i jaśniejsze odpowiedzi, z silniejszymi zdolnościami rozumowania niż OpenAI o1-mini. Testerzy preferowali odpowiedzi o3-mini od o1-mini w 56% przypadków i zaobserwowali 39% redukcję poważnych błędów w trudnych pytaniach ze świata rzeczywistego. Przy średnim wysiłku rozumowania, o3-mini dorównuje wydajności o1 w niektórych z najtrudniejszych ocen rozumowania i inteligencji, w tym AIME i GPQA.

Matematyka konkursowa (AIME 2024)

Wykres słupkowy porównuje dokładność modeli AI w konkursowych pytaniach matematycznych AIME 2024. Starsze modele (szare) uzyskują niższe wyniki, podczas gdy nowsze (żółte) poprawiają się. "o3-mini (high)" osiąga najwyższą dokładność na poziomie 83,6%, co pokazuje znaczny postęp.

Matematyka: Przy niskim wysiłku rozumowania, OpenAI o3-mini osiąga porównywalną wydajność z OpenAI o1-mini, podczas gdy przy średnim wysiłku, o3-mini osiąga porównywalną wydajność z o1. W międzyczasie, przy wysokim wysiłku rozumowania, o3-mini przewyższa zarówno OpenAI o1-mini, jak i OpenAI o1, gdzie zacienione na szaro regiony pokazują wydajność głosowania większościowego (konsensus) z 64 próbkami.

Pytania naukowe na poziomie doktoratu (GPQA Diamond)

Wykres słupkowy porównuje dokładność w pytaniach naukowych na poziomie doktoratu (GPQA Diamond) w różnych modelach sztucznej inteligencji. Starsze modele (szare) osiągają niższe wyniki, podczas gdy nowsze (żółte) poprawiają się. "o3-mini (high)" osiąga 77,0% dokładności, wykazując znaczący postęp w stosunku do wcześniejszych wersji.

Nauka na poziomie doktoratu: W pytaniach z biologii, chemii i fizyki na poziomie doktoratu, przy niskim wysiłku rozumowania, OpenAI o3-mini osiąga wyniki powyżej OpenAI o1-mini. Przy dużym wysiłku, o3-mini osiąga porównywalną wydajność z o1.

FrontierMath

Czarna siatka z wieloma wierszami i kolumnami, oddzielona cienkimi białymi liniami, tworząca uporządkowany i zorganizowany układ.

Matematyka na poziomie badawczym: OpenAI o3-mini z wysokim poziomem rozumowania radzi sobie lepiej niż jego poprzednik na FrontierMath. Na FrontierMath, gdy poproszono o użycie narzędzia Python, o3-mini z wysokim poziomem rozumowania rozwiązuje ponad 32% problemów przy pierwszej próbie, w tym ponad 28% trudnych problemów (T3). Liczby te są tymczasowe, a powyższy wykres pokazuje wydajność bez narzędzi lub kalkulatora.

Kod konkurencji (Codeforces)

Wykres słupkowy porównuje oceny Elo w konkursowych zadaniach kodowania Codeforces dla różnych modeli AI. Starsze modele (szare) uzyskują niższe wyniki, podczas gdy nowsze (żółte) poprawiają się. "o3-mini (high)" osiąga 2073 Elo, pokazując znaczny postęp w stosunku do poprzednich wersji.

Kodowanie w zawodach: W programowaniu konkurencyjnym Codeforces, OpenAI o3-mini osiąga coraz wyższe wyniki Elo wraz ze wzrostem wysiłku rozumowania, przewyższając o1-mini. Przy średnim wysiłku rozumowania dorównuje wydajności o1.

Inżynieria oprogramowania (SWE-bench Verified)

Wykres słupkowy porównuje dokładność w zadaniach inżynierii oprogramowania SWE-bench Verified dla różnych modeli AI. Starsze modele (szare) osiągają niższe wyniki, podczas gdy "o3-mini (high)" (żółty) osiąga najwyższą dokładność na poziomie 48,9%, wykazując poprawę w stosunku do poprzednich wersji.

Inżynieria oprogramowania: o3-mini to nasz najskuteczniejszy wydany model zweryfikowany w SWEbench. Aby uzyskać dodatkowe dane na temat zweryfikowanych wyników SWE-bench z wysokim wysiłkiem rozumowania, w tym z rusztowaniem Agentless typu open source (39%) i rusztowaniem narzędzi wewnętrznych (61%), proszę zapoznać się z naszą kartą systemu.

LiveBench Coding

Tabela porównuje modele AI w zadaniach kodowania, pokazując wskaźniki wydajności i wyniki oceny. Podkreśla różnice w dokładności i wydajności, przy czym niektóre modele przewyższają inne w określonych testach porównawczych.

Kodowanie LiveBench: OpenAI o3-mini przewyższa o1-high nawet przy średnim wysiłku rozumowania, podkreślając jego wydajność w zadaniach kodowania. Przy wysokim wysiłku rozumowania, o3-mini dalej rozszerza swoją przewagę, osiągając znacznie lepszą wydajność w kluczowych metrykach.

Wiedza ogólna

Tabela zatytułowana "Category Evals" porównuje modele AI w różnych kategoriach oceny, pokazując wskaźniki wydajności. Podkreśla różnice w dokładności, wydajności i skuteczności, przy czym niektóre modele przewyższają inne w określonych zadaniach.

Wiedza ogólna: o3-mini przewyższa o1-mini w ocenie wiedzy w domenach wiedzy ogólnej.

Ocena preferencji człowieka

Wykres porównuje współczynniki wygranych dla zadań STEM i innych niż STEM w różnych modelach sztucznej inteligencji. "o3_mini_v43_s960_j128" (żółty) przewyższa "o1_mini_chatgpt" (czerwona linia bazowa) w obu kategoriach, z wyższym współczynnikiem wygranych w zadaniach STEM.

Wykres porównuje współczynniki wygranych przy ograniczeniach czasowych i poziomach poważnych błędów w modelach sztucznej inteligencji. "o3_mini_v43_s960_j128" (żółty) przewyższa "o1_mini_chatgpt" (czerwona linia bazowa) pod względem wskaźnika wygranych i znacznie zmniejsza liczbę poważnych błędów.

Ocena ludzkich preferencji: Oceny zewnętrznych testerów-ekspertów również pokazują, że OpenAI o3-mini daje dokładniejsze i bardziej przejrzyste odpowiedzi, z silniejszymi zdolnościami rozumowania niż OpenAI o1-mini, szczególnie w przypadku STEM. Testerzy preferowali odpowiedzi o3-mini od o1-mini w 56% przypadków i zaobserwowali 39% redukcję poważnych błędów w trudnych pytaniach w świecie rzeczywistym.

Szybkość i wydajność modelu

Dzięki inteligencji porównywalnej z OpenAI o1, OpenAI o3-mini zapewnia szybszą wydajność i lepszą efektywność. Poza ocenami STEM podkreślonymi powyżej, o3-mini wykazuje lepsze wyniki w dodatkowych ocenach matematycznych i merytorycznych przy średnim wysiłku rozumowania. W testach A/B, o3-mini dostarczało odpowiedzi o 24% szybciej niż o1-mini, ze średnim czasem odpowiedzi wynoszącym 7,7 sekundy w porównaniu do 10,16 sekundy.

Porównanie opóźnień między o1-mini i o3-mini (średnie)

Wykres słupkowy porównuje opóźnienia między modelami "o1-mini" i "o3-mini (medium)". "o3-mini" (jaśniejszy żółty) ma niższe opóźnienia, co wskazuje na szybszy czas reakcji, podczas gdy "o1-mini" (ciemniejszy żółty) zajmuje średnio więcej czasu.

Opóźnienie: o3-mini ma średnio o 2500 ms krótszy czas do pierwszego tokena niż o1-mini.

Bezpieczeństwo

Jedną z kluczowych technik, których użyliśmy, aby nauczyć OpenAI o3-mini bezpiecznego reagowania, jest celowe dostosowanie, w którym wytrenowaliśmy model, aby rozumował o napisanych przez człowieka specyfikacjach bezpieczeństwa przed udzieleniem odpowiedzi na monity użytkownika. Podobnie jak w przypadku OpenAI o1, stwierdzamy, że o3-mini znacznie przewyższa GPT-4o w trudnych ocenach bezpieczeństwa i jailbreak. Przed wdrożeniem dokładnie oceniliśmy ryzyko związane z bezpieczeństwem o3-mini, stosując takie samo podejście do gotowości, zewnętrznego red-teamingu i ocen bezpieczeństwa jak w przypadku o1. Dziękujemy testerom bezpieczeństwa, którzy zgłosili się do testowania o3-mini we wczesnym dostępie. Szczegóły poniższych ocen, wraz z kompleksowym wyjaśnieniem potencjalnych zagrożeń i skuteczności naszych środków zaradczych, są dostępne w karcie systemu o3-mini.

Oceny niedozwolonej zawartości

Tabela porównuje modele AI pod względem wskaźników bezpieczeństwa, oceniając wydajność w różnych kategoriach ryzyka. Podkreśla różnice w zgodności z wymogami bezpieczeństwa, przy czym niektóre modele lepiej radzą sobie z ograniczaniem potencjalnego ryzyka.

Ocena jailbreaka

Tabela porównuje modele AI pod względem wskaźników bezpieczeństwa w wielu kategoriach ryzyka, pokazując różnice w wydajności. Podkreśla różnice w ograniczaniu ryzyka, przy czym niektóre modele wykazują większą zgodność i bezpieczniejsze reakcje.

Co dalej

Wydanie OpenAI o3-mini stanowi kolejny krok w misji OpenAI polegającej na przesuwaniu granic opłacalnej inteligencji. Optymalizując rozumowanie dla dziedzin STEM przy jednoczesnym utrzymaniu niskich kosztów, sprawiamy, że wysokiej jakości sztuczna inteligencja jest jeszcze bardziej dostępna. Model ten kontynuuje nasze osiągnięcia w zakresie obniżania kosztów inteligencji - zmniejszając ceny za token o 95% od czasu uruchomienia GPT-4 - przy jednoczesnym zachowaniu najwyższej klasy możliwości rozumowania. Wraz ze wzrostem popularności sztucznej inteligencji, pozostajemy liderem w tej dziedzinie, budując modele, które równoważą inteligencję, wydajność i bezpieczeństwo na dużą skalę.

Autorzy

OpenAI

Szkolenie

Brian Zhang, Eric Mitchell, Hongyu Ren, Kevin Lu, Max Schwarzer, Michelle Pokrass, Shengjia Zhao, Ted Sanders

Eval

Adam Kalai, Alex Tachard Passos, Ben Sokolowsky, Elaine Ya Le, Erik Ritter, Hao Sheng, Hanson Wang, Ilya Kostrikov, James Lee, Johannes Ferstad, Michael Lampe, Prashanth Radhakrishnan, Sean Fitzgerald, Sebastien Bubeck, Yann Dubois, Yu Bai

Frontier Evals & Preparedness

Andy Applebaum, Elizabeth Proehl, Evan Mays, Joel Parish, Kevin Liu, Leon Maksin, Leyton Ho, Miles Wang, Michele Wang, Olivia Watkins, Patrick Chao, Samuel Miserendino, Tejal Patwardhan

Inżynieria

Adam Walker, Akshay Nathan, Alyssa Huang, Andy Wang, Ankit Gohel, Ben Eggers, Brian Yu, Bryan Ashley, Chengdu Huang, Christian Hoareau, Davin Bogan, Emily Sokolova, Eric Horacek, Eric Jiang, Felipe Petroski Such, Jonah Cohen, Josh Gross, Justin Becker, Kan Wu, Kevin Whinnery, Larry Lv, Lee Byron, Manoli Liodakis, Max Johnson, Mike Trpcic, Murat Yesildal, Rasmus Rygaard, RJ Marsan, Rohit Ramchandani, Rohan Kshirsagar, Roman Huet, Sara Conlon, Shuaiqi (Tony) Xia, Siyuan Fu, Srinivas Narayanan, Sulman Choudhry, Tomer Kaftan, Trevor Creech

Wyszukiwanie

Adam Fry, Adam Perelman, Brandon Wang, Cristina Scheau, Philip Pronin, Sundeep Tirumalareddy, Will Ellsworth, Zewei Chu

Produkt

Antonia Woodford, Beth Hoover, Jake Brill, Kelly Stirman, Minnia Feng, Neel Ajjarapu, Nick Turley, Nikunj Handa, Olivier Godement

Bezpieczeństwo

Andrea Vallone, Andrew Duberstein, Enis Sert, Eric Wallace, Grace Zhao, Irina Kofman, Jieqi Yu, Joaquin Quinonero Candela, Madelaine Boyd, Mehmet Yatbaz, Mike McClay, Mingxuan Wang, Saachi Jain, Sandhini Agarwal, Sam Toizer, Santiago Hernández, Steve Mostovoy, Young Cha, Tao Li, Yunyun Wang

Redteaming zewnętrzny

Lama Ahmad, Troy Peterson

Kierownicy programów badawczych

Carpus Chang, Kristen Ying

Przywództwo

Aidan Clark, Dane Stuckey, Jerry Tworek, Jakub Pachocki, Johannes Heidecke, Kevin Weil, Liam Fedus, Mark Chen, Sam Altman, Wojciech Zaremba

+ wszyscy współpracownicy stojący za o1.